RAG AI staat voor Retrieval Augmented Generation en is een AI-architectuur voor betrouwbare AI in organisaties. In plaats van antwoorden te genereren op basis van algemene trainingsdata, combineert RAG AI generatieve AI met gecontroleerde, interne kennisbronnen. De AI zoekt eerst relevante informatie op uit bekende bronnen en gebruikt die informatie vervolgens om een antwoord te formuleren.

RAG AI koppelt generatieve AI aan een zoeklaag over interne kennis. In plaats van direct een antwoord te genereren, haalt het systeem eerst relevante informatie op en selecteert deze als context voor het taalmodel.

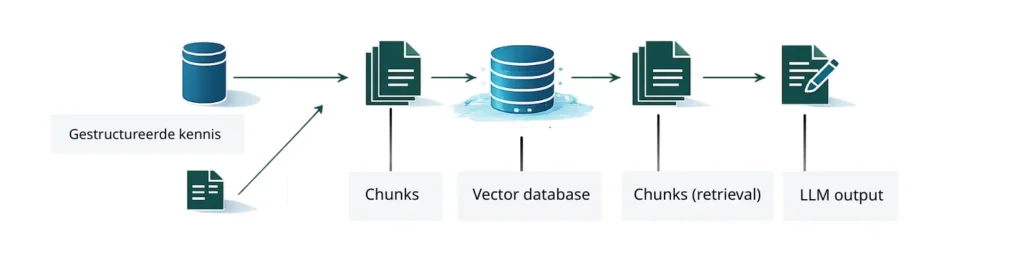

Het proces bestaat uit drie stappen, zoals weergegeven in de afbeelding.

RAG AI zoekt relevante informatie in gecontroleerde kennisbronnen zoals beleidsdocumenten, handleidingen, kennisbanken of FAQ’s. Deze kennis is opgesplitst in kleinere delen (chunks) en opgeslagen in een vector database.

Uit de vector database worden alleen de meest relevante chunks geselecteerd. Deze vormen de context voor het AI-model en bepalen welke informatie wordt gebruikt in het antwoord.

Het Large Language Model (LLM) genereert vervolgens een antwoord op basis van de geselecteerde chunks. Het model verzint geen informatie buiten de beschikbare kennis.

Zoals in de afbeelding te zien is, wordt kennis eerst opgesplitst, opgeslagen en pas bij een vraag opnieuw geselecteerd. Hierdoor krijgt de gebruiker geen algemene tekst, maar een antwoord dat direct is gebaseerd op relevante organisatiekennis.

RAG AI levert geen samenvatting, maar een contextueel antwoord.

RAG AI wordt vooral ingezet in organisaties waar betrouwbaarheid en verantwoording essentieel zijn, zoals:

In deze omgevingen is “ongeveer goed” niet acceptabel.

Meer weten over RAG AI? Lees ook het artikel Waarom RAG AI essentieel is voor betrouwbare AI in organisaties.

Founder Qsource